如果能方便的掌握蜘蛛在網站中的蹤跡,便能更好的“對癥下藥”,更加方便的對網站進行SEO優化了,那么這一次的wordpress開發教程就教大家如何便捷的獲取蜘蛛的爬行記錄

對于一些對SEO有研究需求的站長來說,如果能方便的掌握蜘蛛在網站中的蹤跡,便能更好的“對癥下藥”,更加方便的對網站進行SEO優化了,那么這一次的wordpress開發教程就教大家如何便捷的獲取蜘蛛的爬行記錄。

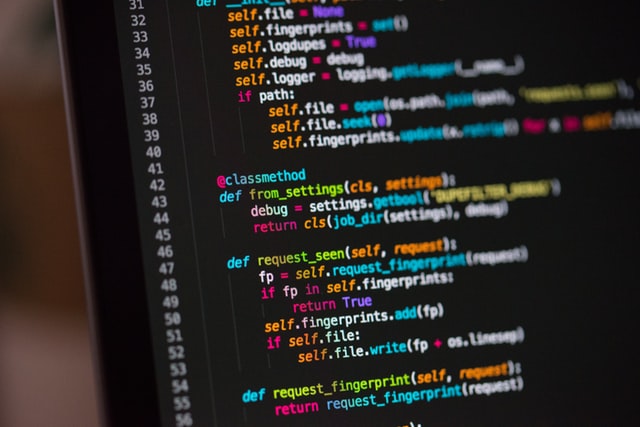

每次打開服務器端訪問日志查看非常麻煩,特別是當日志文件比較大時更是不便。最好的辦法就是在線直接打開看蜘蛛爬行記錄。為此,我們可以免插件使用純 PHP 代碼在wordpress主題中來實現這個功能。

將以下代碼插入 到主題根目錄下的funtion.php 文件的<?php下面,并在網站根目錄下創建一個名為 robotslogs.txt 的文件即可,文件名可自定義。

// 記錄蜘蛛訪問記錄

function get_naps_bot(){

$useragent = strtolower($_SERVER['HTTP_USER_AGENT']);

if (strpos($useragent, 'googlebot') !== false){

return 'Googlebot';

}

if (strpos($useragent, 'bingbot') !== false){

return 'Bingbot';

}

if (strpos($useragent, 'slurp') !== false){

return 'Yahoobot';

}

if (strpos($useragent, 'baiduspider') !== false){

return 'Baiduspider';

}

if (strpos($useragent, 'sogou web spider') !== false){

return 'Sogouspider';

}

if (strpos($useragent, 'haosouspider') !== false){

return 'HaosouSpider';

}

if (strpos($useragent, 'yodaobot') !== false){

return 'YodaoBot';

}

return false;

}

function nowtime(){

date_default_timezone_set('Asia/Shanghai');

$date=date("Y-m-d G:i:s");

return $date;

}

$searchbot = get_naps_bot();

if ($searchbot) {

$tlc_thispage = addslashes($_SERVER['HTTP_USER_AGENT']);

$url=$_SERVER['HTTP_REFERER'];

$addr=$_SERVER['REMOTE_ADDR'];

$file="robotslogs.txt"; //根目錄下記錄蜘蛛訪問的文件

$time=nowtime();

$data=fopen($file,"a");

$PR="$_SERVER[REQUEST_URI]";

fwrite($data,"[$time] - $addr - $PR - $searchbot $tlc_thispage \r\n");

fclose($data);

}注意需為 robotslogs.txt 設置可寫權限,最好是 777 (慎用)權限,755 權限某些主機配置下可能存在無法寫入的情況。以上代碼能記錄搜索蜘蛛的基本抓取信息,完成以后,一般 24 小時候,就可以看到你“robotslogs.txt”當中已經滿是數據的了。

說到SEO方面,那就不得不提一下robots.txt文件了,如果你還不知道這是什么的話,可以看看下面這篇wordpress開發教程文章: